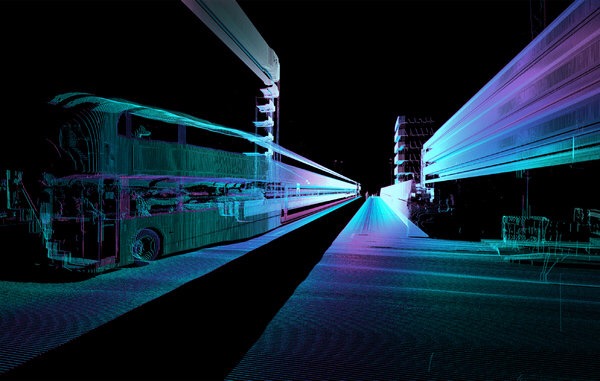

Ci sono occhi non umani in giro per le città che fanno foto, registrano video e hanno allucinazioni. Gli occhi non umani di robot alla guida di automobili i cui proprietari si trovano altrove. Di queste automobili utilizzate da Google, BMW, Ford ne parla un bellissimo articolo sul NYT e sono il sogno di un autostoppista che va in giro per le città e registra strade, palazzi, piazze e tutti gli incontri umani per creare mappe di ogni genere. Le macchine “osservano” attraverso un sistema di scannerizzazione particolare denominato “lidar” (una combinazione di light e radar). Questo sistema cattura foto in una prospettiva volumetrica costruendo modelli in 3d dell’ambiente circostante con un dettaglio ben superiore alle capacità dell’occhio umano. L’estrema accuratezza del lidar è tale che ci sono compagnie (CyArk) che lo usano persino come strumento di conservazione archeologica, vale a dire registrando tutti quei siti storici che hanno un’alta probabilità di essere distrutti.

Sight Lines from ScanLAB.

Nell’articolo ci sono dei passaggi particolarmente affascinanti dove si fa notare che i software dei robot che elaborano i dati si trovano in difficoltà in ambienti urbani caratterizzati da fattori non lineari come un temporale, un riflesso solare su una vetrina o varie incongruenze geometriche:

“Questo significa che le città dovrebbero essere ridisegnate o comunque modificate nel tempo per sintonizzarle con il particolar modo in cui gli occhi del robot fanno esperienza dell’ambiente urbano. L’atro lato della medaglia è costituito dal fatto che nelle distorsioni applicate dal robot emergono versioni del mondo urbano alternative: paesaggi paralleli visti solo dalla macchina – una tecnologia che percepisce oggetti e stimoli invisibili agli esseri umani e che nonostante tutto non hanno effetti reali nella realtà cittadina. Se possiamo imparare dai bias umani, forse possiamo imparare qualcosa dalle allucinazioni delle macchine.”

Trovo queste osservazioni davvero fantastiche. Cominciare ad apprendere dagli errori del robot apre nuovi scenari sociali con i robot grazie alla condivisione di conoscenza e di errori con il loro punto di vista. Le distorsioni delle immagini non sono così scorrette ma elaborazioni alternative del mondo urbano, elaborazioni che non devono essere corrette, lo deve essere la struttura urbana. E la rielaborazione percettiva operata dal robot ci fa pensare il mondo non dal punto di vista umano ma robotico, di un’intelligenza non biologica che fa esperienza del mondo falsificanfo le proprie aspettative (o algoritmi).

“La Londra che queste macchine ci rivelano è un paesaggio di monumenti invecchiati ed eleganti edifici, ma anche un ambiente inquietante di sdoppiamenti e fantasmi digitali. L’autobus cittadino scannerizzato un’infinità di volte viene “allungato temporalmente” in una mega struttura senza solidità che occupa una serie di strade nello stesso tempo. Altri palazzi sembrano ripetersi e balbettare, un quartiere del Parlamento rimbalza su se stesso in lontananza. Impiegati seduti al tavolo di un bar per un pasto si tramutano in spettrali silouette che appaiono improvvisamente come aberrazioni sul campo visivo. Colonne di foglie si dissolvono nel cielo come vapore. Sono allucinazioni di macchine nevrotiche.”

E così arriviamo ad un’altra conseguenza, cioè la prospettiva clinica della macchina. Forse gli psicologi un giorno potranno ricavare informazioni illuminanti sui meccanismi che generano allucinazioni dal lavoro quotidiano di un robot annoiato, meditabondo ed esteta in giro per le città.

link all’articolo sul New York Time